說到屏蔽搜索蜘蛛的抓取,自然而然的就會想到robots.txt文檔。robots.txt是什麼?其實在此前筆者也已經對此進行了基礎的說明。robots.txt是一種存放在網站空間根目錄下的文本文件,是一種協議,用來告訴搜索蜘蛛網站中哪些可被爬行抓取,哪些不可被爬行抓取。然而,在這裡,筆者有著這麼一個疑問,robots.txt是否能徹底屏蔽蜘蛛的爬行抓取呢?

robots.txt能屏蔽蜘蛛的爬行抓取

近日,好友遇到了這麼一個問題:“我明明用robots.txt屏蔽了wordpress中的目錄文件呀,為什麼蜘蛛每日仍然照常爬行呢?”而後,筆者自然便查網站robots.txt文檔,以下便是對wordpress目錄屏蔽設置:

Disallow: /wp-admin

Disallow: /wp-content

Disallow: /wp-includes

在查看過後,發現了這麼一個問題,這是目錄文件屏蔽,然而,這屏蔽設置後邊卻似乎缺少了,而進行咨詢時,好友卻是這麼認為:“目錄文件前邊加上了/就可以了,後邊加不加都一樣的呀”。對此,筆者卻是另一種看法,在後邊加上與未加上/,對於蜘蛛而言是兩種概念,加上了是告訴蜘蛛,這是一個文件夾,而未加上即告訴蜘蛛這是一個文件,也因此導致明明在robots.txt上做好了設置,卻沒能有效的屏蔽。當然這僅僅是筆者的個人看法。

繼而,好友聽從建議將robots.txt修改為:

Disallow: /wp-admin/

Disallow: /wp-content/

Disallow: /wp-includes/

成功修改後便在百度站長平台進行提交重新生成操作(需要注意的是,若不主動提交生成,靠蜘蛛自行生產的話,耗時較長的喔),在當天也就生效了。隔日後再對日志進行查看,發現蜘蛛對這三個wordpress下的目錄真的不再爬行抓取了。

從這麼一點上看,在我們進行網站SEO優化之時,著實不能忽略任何細節,僅僅一個,可帶來的卻是不一樣的效果。

robots.txt不能徹底屏蔽蜘蛛的爬行抓取

而在這一問題解決後,好友在這文件屏蔽上卻又有了另一問題:“明明把某個目錄屏蔽了呀,為什麼蜘蛛還是能夠抓取收錄該目錄下的某個文件呢?”

那麼,在這裡就需要做一個說明,robots.txt協議並非是一個標准,一個規范,只是約定俗成而已罷了,通常搜索引擎會識別這個文件,但也有一些特殊情況。(如之前的360事件就不作為此次討論內容)

無論是百度亦或是谷歌,某個頁面只要有其他網站鏈接到該頁面的話,同樣有可能會被索引和收錄。要想徹底屏蔽頁面文件被谷歌索引的話(即使有其他網站鏈接到該頁面文件),則需要在頁面head中插入noindex元標記或x-robots-tag。如下:

<meta name=“googlebot” content=“noindex”>

當谷歌蜘蛛看到頁面上著noindex的元標記,就會將此頁從谷歌搜索結果中完全丟棄,無視是否還有其他頁鏈接到此頁。

而百度呢?對於百度而言,並不支持如谷歌那般通過noindex完全將網頁從索引上刪除,僅支持noarchive元標記來禁止百度顯示網頁快照。具體語句如下:

<meta name=“Baiduspider” content=“noarchive”>

上面這個標記只是禁止百度顯示該頁面快照,但百度仍會為其建索引,並在搜索結果中顯示網頁摘要。

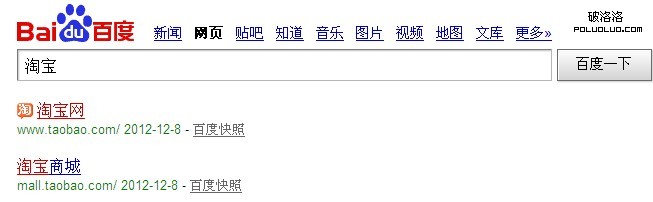

眾所周知,淘寶網通過robots.txt全站屏蔽百度蜘蛛,可為什麼我們在百度搜索淘寶網時第一個結果也是淘寶網首頁地址呢?而在我們查看該頁面快照時卻是顯示空白?因此看來,網站只能禁止百度快照的顯示,卻無法做到禁止百度為網頁建索引。

結束語:

回到筆者在文章首段所說到的疑問,robots.txt是否能徹底屏蔽蜘蛛的爬行抓取呢?相信在看到這麼一個問題,會有這麼一部分朋友的回答是肯定的。而這只能說,我們都缺少了善於去發現的心,而對於沒能有效屏蔽蜘蛛抓取,只能說明咱們的優化工作做得不夠精細。

由這麼兩個robots.txt的小問題上,筆者認為,阻止我們進階為SEO高手的或許便是那善於發現問題的心和精細化的執行力。