互聯網中存在了大量的重復頁面,據統計表明近似重復頁面的數量占據網站總數量的29%,而完全重復頁面占據了22%。這些重復的頁面對搜索引擎來說占據了很多的資源,因此搜索引擎對頁面的去重也是搜索引擎中很重要的一個算法。因此今天就跟大家分析下搜索引擎頁面去重算法-I-Match算法。

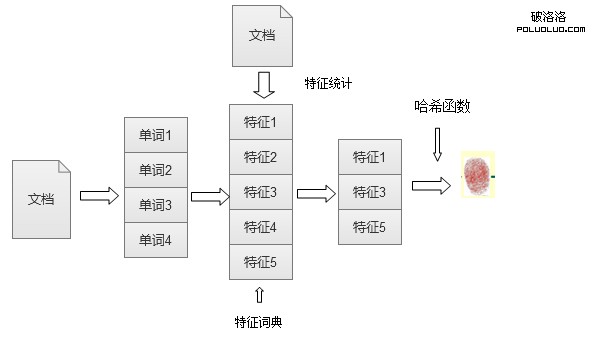

對於I-Match算法來說主要是根據大規模的文本集合進行統計,對於文本中出現的所有單詞,按照單詞的IDF(逆文本詞頻因子)來進行由高到低的排序,除去得分最高和得分最低的單詞,保留剩下的單詞最為特征詞典。這一步驟主要是刪除文本中無關的關鍵詞,保留重要關鍵詞。下面是I-Match流程示意圖:

I-Match流程示意圖

獲得全局特征詞典之後,對需要去重的頁面,掃描下就能獲得該頁面上出現的所有單詞,對於這些單詞根據特征詞典過濾:保留在特征詞典上出現的單詞,用來表達文檔的主要內容,刪除沒有在特征詞典中出現的內容。提取出對應的特征詞之後在利用哈希函數對特征詞匯進行哈希計算,獲得的數值就是該文檔的文本指紋。

所有文檔都統計完之後如果想查看兩篇文檔是否重復只需要查看文檔的文本指紋是否近似,如果近似則表示兩篇文檔重復。這樣的比對方式很直觀而且效率也很高,去重效果比較明顯。

我們seo在做文章偽原創的時候經常會把文章的詞語和段落調換位置,以此想欺騙搜索引擎認為這是一篇原創的文章,但是I-Match對文檔之間的單詞順序並不敏感。如果兩篇文章中包含的單詞一樣僅僅是調換了單詞的位置,那麼I-Match算法還是將兩篇文章認為是重復文章。

但是這個算法還是有很多問題存在。1,容易出現誤判。尤其是面對短文本的時候,短文本本身單詞比較少,經過特征詞典過濾之後只保留很少的特證詞,這樣容易把兩篇原本不重復的文檔誤認為重復,這個對短文檔來說情況比較嚴重。2.穩定性不好,對文檔修改敏感。假如對文檔A做出一點小修改後生成文檔B,那麼這個算法很可能判斷出兩篇文檔為不重復文檔。例如:我們在文檔A中加入一個單詞H,生成文檔B。I-Match算法在進行計算的時候,兩篇文章僅僅相差一個單詞H,如果單詞H不再特征詞典中那麼兩篇文章的特證詞相同即判定為重復文檔,但是會出現這種情況,單詞H出現在特征詞典中,那麼文本B比文檔A多出一個特征,該算法很可能就會判定兩篇文檔不重復。這就是I-Match最大的一個問題。

基於I-Match出現的這種問題,有人對該算法進行了改進。原算法對文檔的改變非常敏感,主要是因為對單一特征詞典的過度依賴,改進後的I-Match就是減少對特征詞典的依賴性。可以采用多個特征詞典,只要每個特征詞典大體相近就可以忽略細小的差別。

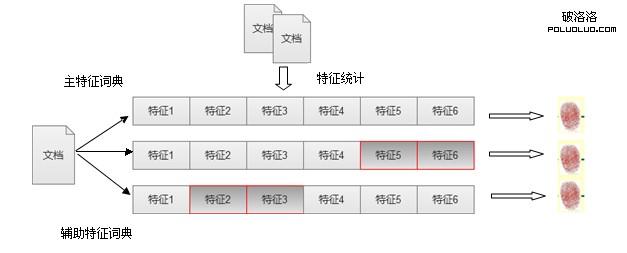

改變後的I-Match算法主要是:類似I-Match原始算法,形成一個特征詞典,為了和其他詞典相區別可以成為主特征詞典;然後根據主特征詞典衍生出若干小的輔助特征詞典。為了保證特征詞典的主體相同,可以從主特征詞典中隨機刪除若干詞典項然後生成一個新的特征詞典,這個特征詞典就叫做輔助特征詞典,重復若干次數後就可以獲得若干輔助特征詞典。當兩篇文檔進行對比的時候可以對主特征詞典和輔助特征詞典一起比對,只要保證每個特征詞典的大體內容相同,忽略細小差異就能判定文檔是否重復。下圖是I-Match改進後的示意圖:

I-Match算法改進

上圖演示中有兩個輔助特征詞典,主特征詞典拋棄了特征5和特征6形成輔助特征詞典1,主特征詞典拋棄了特征2和特征3形成了輔助特征詞典2。並且根據三個特征詞典分別形成了文本指紋。如果兩篇文檔有兩個指紋信息相同那麼即可判定兩篇文檔重復。

改進後的I-Match算法大大提高了文檔去重的成功率,增加了算法的穩定性。

對SEO啟發:傳統的偽原創文章,對一篇文章進行簡單的修改,首尾做一些小的變動,然後把中間段落調整順序,這個對搜索引擎來說都是沒有意義的,還是可以判斷出兩篇文章是否重復。因為我們對於文章的建設還是要原創,或者對原文章進行比較大的改動,使兩篇文章的特征詞典發生改變。

詞語解釋:

IDF 逆文檔詞頻因子:衡量一個詞普遍重要度的衡量因子,某一特定詞語的IDF,可用總文件數目除以含有該詞語文檔數目,將得到的商取對數得到。

表示文檔總數 n表示含有詞條k的文檔數量。