摘要:剛接手不久一個B2B電子商務平台、由於產品詳情頁有兩種不同形式的URL:有32位、也有16位,所以需要對URL進行統一規范;

那麼是采用32位的:http://www.csc86.com/product/5475beae-8324-4d52-911d-d53b78926e1a.html標准(長地址);

還是采用16位:http://www.csc86.com/product/79377.html(短地址)標准、當時考慮原則是兩種不同形式的URL百度索引數據及兩種不同形式的URL收錄速度、也就是說哪URL百度索引數據多且URL收錄速度快那就采用哪種URL標准;

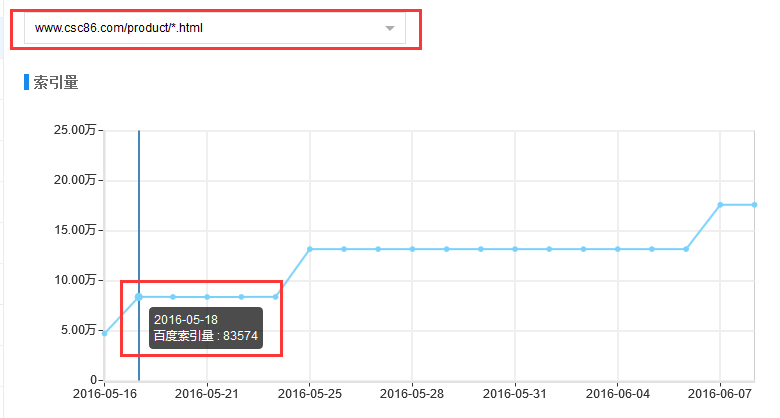

所以在百度站長工具自定義規則,分別查看兩種特征頁面集合的索引量數據

16位(短地址)的URL百度索引量數據

32位(長地址)的URL百度索引量數據

說明:

1、32位(長地址)的URL數據存量是16位(短地址)數據存量大概4倍

2、05-18當天16位(短地址)的URL索引量數據增加83574,而32位(長地址)URL索引量數據則增加2090

3、針對URL索引量增加沒有做任何人工干預

也就是說16位(短地址)URL百度索引數據多於32位URL且短URL收錄速度快,所以決定采用16位(短地址)做為產品詳情URL規范;

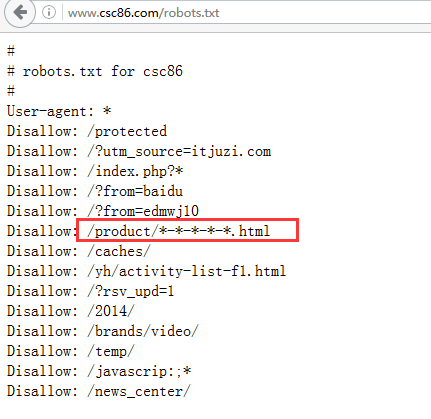

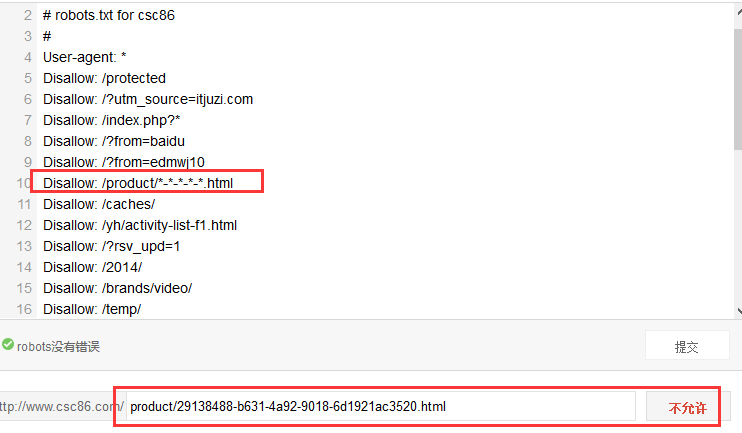

問題:05-19號針對robots文件屏蔽32位URL搜索引擎相關抓取規則

robots文件如下:

但06-07號32位URL索引量還是出現大幅增長情況

當然看到這個數據第一反應就是robots規則不對,所以對robots進行檢查、但發現robots沒有問題、屏蔽規則也檢測正常;

在06-09號對此問題進行反饋、得到反饋的結果是百度這邊處理時間較長的, 所以百度處理此類問題的反應超級慢,所以建議在處理此類問題時最好使用百度站長具檢測robots 並進行強制更新。

未經裕騰智工作室授權許可任何人不得復制、轉載、或以其他任何方式使用裕騰智工作室的內容。裕騰智工作室保留追責權利。文章出處:裕騰智工作室 http://www.ying88.net/biji_share/57.html