百度站長平台提供了一個很好的robots.txt自動生成工具,利用它我們可以很方便的寫出robots.txt,通過robots.txt阻止搜索引擎收錄你不想要被收錄的頁面及目錄,還可以阻止及引導蜘蛛爬行更多的頁面,減少蜘蛛的爬行量,提高蜘蛛的爬行效率,有效的提升更多的頁面被收錄。

前面我們介紹了通過IIS日志分析讓你更好的了解網站運行情況,可以通過IIS日志查詢到蜘蛛爬行中返回404狀態的頁面,這裡我們可以用robots.txt禁止蜘蛛爬行。

百度站長平台注冊及網站驗證方法這裡就不說了,下面講講Robots工具的使用方法:

通過上圖可以看到,蜘蛛返回404狀態的頁面都是網站改版前使用的網址,現在都不存在了,但是搜索引擎數據庫還保存有記錄,所以每天蜘蛛還是會來抓取這個頁面的數據的,還有的時候是蜘蛛順著別的網站上面留下的外鏈爬過來的。

下面我們演示怎樣將通過光年SEO日志分析軟件生成的日志報告中顯示的404狀態不存在的頁面都屏蔽掉,不讓蜘蛛抓取。

首先登陸百度站長平台,點擊左邊菜單的“Robots工具”進入Robots自動生成界面。

然後將上圖中404狀態的頁面路徑整理後復制到Robots工具輸入框中。

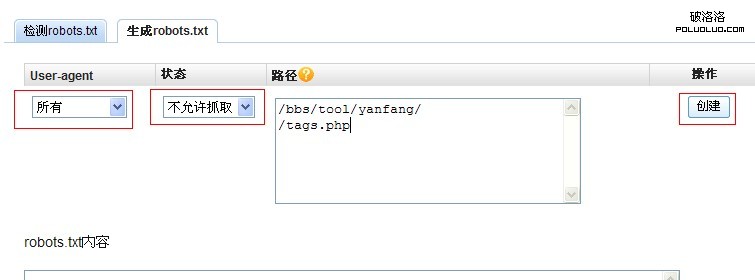

User-agent底下選擇“所有”,狀態選擇“不允許抓取”,輸入路徑後點擊後面的“創建”,上圖我們測試了兩個路徑,分別是目錄和一個文件,可以一下子輸入多個路徑,建議先在記事本裡面將網址整理好再提交,一行一個路徑。

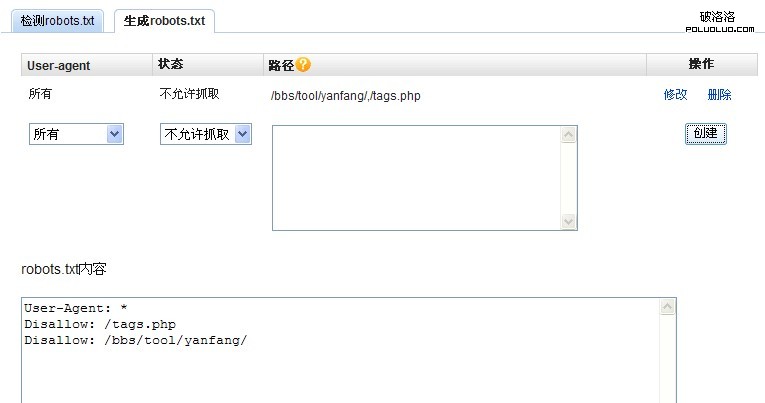

點擊“創建”以後,可以看到,底下的robots.txt內容中出現的代碼,而且百度站長平台Robots工具有一個好處就是,不論你是多層目錄還是網站單文件頁面,它都自動識別後排序生成,不會造成單頁面和目錄順序錯亂造成蜘蛛抓取robots.txt的時候出現錯誤,所以我們大不必擔心格式問題了。

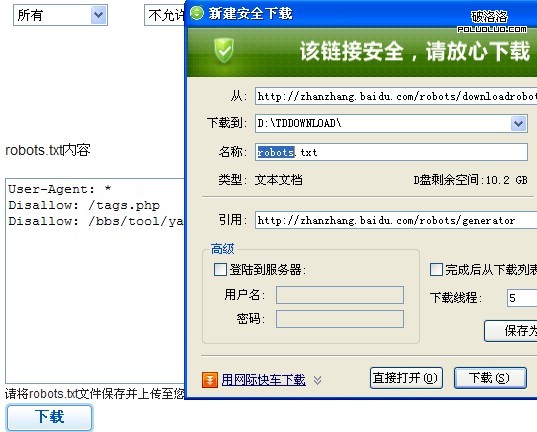

將所有需要屏蔽的頁面或路徑都生成以後,點擊底下的“下載”,然後將robots.txt上傳到網站根目錄就可以了。

小提示:robots.txt上傳以後,我們可以通過robots檢測工具來實驗一下robots.txt是否有效或者有什麼錯誤,CHINAZ、SEOWHY、愛站等網站都有相關工具的。

建議用一個記事本收集404狀態頁面,然後整理存檔,每次發現IIS日志中有新的404頁面出現,就在以前的存檔裡面查找一下是否有重復,沒有重復就可以直接添加到robots.txt文件中了。