網站的收錄比例往往是很多優化人員極其重視的一個指標之一,網站的收錄好壞,從根本上能夠決定網站的流量多少,畢竟有收錄才會有排名,有排名才可能會有流量。但是網站收錄是一個困擾許多站長的難題,很多站長拼命努力做站,卻發現蜘蛛並不青睐自己的網站,收錄數量也寥寥無幾。

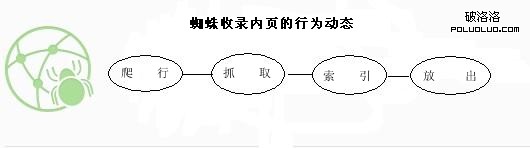

當站長們苦惱網站為何不被收錄時,應該去想想,究竟是誰在決定網站的收錄?答案很明顯,就是搜索引擎蜘蛛。既然搜索引擎蜘蛛是收錄的決定者,我們就應該從蜘蛛的工作原理入手,深入去研究一下,然後抓住蜘蛛工作原理規律去制定方案對策,來實現網站的收錄最大化。好了,廢話不多說,下面筆者就來簡單和大家討論一下吧。

原理一:通過網站鏈接爬行網站內頁

搜索引擎機器人之所以被稱之為蜘蛛,原因就是其行為極其類似蜘蛛。蜘蛛會通過網站上的網狀鏈接來爬行一個網站的頁面,如果一個網站沒有任何鏈接入口,那麼蜘蛛將會無從下手。因此,要實現網站收錄最大化,第一步工作就是要為蜘蛛提供更多的、更加緊密鏈接入口。最簡單的方法就是為蜘蛛制造更多內部鏈接,比如筆者的一個網站就是如此,筆者在每次編輯完文章後都會添加一到兩條“閱讀推薦”的鏈接,為蜘蛛提供一個爬行入口,如下圖:

原理二:根據網站結構情況來抓取內頁

當蜘蛛尋找到一個爬行入口後,它就會開始進行下一步工作——抓取頁面內容。但是要注意的是,蜘蛛是不可能一次性把網站上的內容都抓取的,它是會根據網站結構情況去抓取,也就是說,如果網站的結構不合理,將會成為蜘蛛抓取頁面的一個絆腳石。因此,站長們應該從兩個方面去解決網站內部結構問題:

(1)精簡flash以及js代碼。百度也曾經聲明過,蜘蛛對於含有過量flash元素的網站是比較難以抓取的,因此站長們應該盡量不在網站上使用flash,即使要用也要選取容量較小的flash;對於js代碼也是如此,過於華麗的js功能其實是不必要的,這只會加重蜘蛛的抓取壓力,因此,把冗余的js去掉或者合並是一個明智的選擇。

(2)徹底清除網站死鏈接。網站死鏈接的產生有時是不可避免的,但是如果不及時注意清理,也會成為蜘蛛抓取頁面的一個絆腳石。站長們千萬不要嫌麻煩,最好養成每天一查的好習慣,只要一發現死鏈接,就應該到ftp刪除之,又或者到百度站長平台上提交死鏈接,告訴蜘蛛這是一個死鏈接,不要再去爬行,這樣才能讓蜘蛛增加對你的網站好感度。

原理三:根據內容質量來嘗試索引頁面

網站的結構如果沒有什麼大問題的話,蜘蛛一般都能夠順利抓取頁面,然後進行下一步的工作——索引頁面內容。這一步工作是重中之重,如果成功索引,那麼你的網站頁面內容也就算成功被收錄了,而蜘蛛索引頁面的決定性因素就是頁面的內容質量。如果一個網站的頁面內容過關,或者內容重復度過高都會被蜘蛛輕易否決。所以,為了讓蜘蛛成功索引我們的頁面,站長們應該要著重網站的內容建設,做到規律更新,即使無法原創也要做到深度偽原創,盡量為蜘蛛提供新鮮的內容。當然我們也可以通過站長工具或者蜘蛛日志來觀察蜘蛛對我們的網站索引情況:

原理四:考察過後再發出內頁

當蜘蛛完成上面三步工作,並成功索引頁面後,那麼就可以說我們的頁面內容被真正收錄了,但是你也不要興奮過早,因為收錄並不等於頁面被放出了。蜘蛛有一個工作原理,就是索引後不會立刻放出頁面內容,而是會選擇性地考察一下才會放出,這段時期我們不必過分緊張,只要繼續做好內容更新,耐心等待,不要犯什麼大錯誤,我們的頁面內容很快就可以放出了!

蜘蛛只是一個用代碼編寫的程序機器人,它的規律始終是被人掌握在手上的,因此我們網站收錄不理想的時候應該多去研究一下蜘蛛的工作原理,並自己總結出一些規律來制定方案來解決收錄問題,這樣我們的網站才能實現收錄最大化。

本文專為北京大學人民醫院網上掛號http://www.bjrmyyghw.com供稿,希望轉載的朋友加上一條鏈接,謝謝大家支持!

注:相關網站建設技巧閱讀請移步到建站教程頻道。

收藏本文- 上一頁:站長朋友們,你們准備好變革了嗎?

- 下一頁:談談被誤解的交換友情鏈接條件